La vision artificielle est une méthode d'avenir pour la reconnaissance automatisée des plantes adventices

Univ. Liège - Gembloux Agro-Bio Tech. Unité de Mécanique et Construction. Passage des Déportés, 2. B-5030 Gembloux (Belgium).

Univ. Liège - Gembloux Agro-Bio Tech. Unité de Mécanique et Construction. Passage des Déportés, 2. B-5030 Gembloux (Belgium).

Univ. Liège - Gembloux Agro-Bio Tech. Unité de Mécanique et Construction. Passage des Déportés, 2. B-5030 Gembloux (Belgium). E-mail : mfdestain@ulg.ac.be

Reçu le 24 septembre 2010, accepté le 8 février 2011.

Résumé

Les adventices entrent en compétition avec les cultures pour la lumière, l'eau, les nutriments et l'espace. De ce fait, elles réduisent les rendements, peuvent rendre la récolte difficile et risquent d'affecter la qualité des produits. Elles sont détruites à l'aide de méthodes chimiques, non chimiques et intégrées. Pour réaliser une destruction localisée, il est possible de coupler ces techniques à un système de vision artificielle pour assurer la reconnaissance automatique des adventices par rapport aux plantes cultivées. Les problèmes les plus compliqués se rencontrent lorsque les adventices sont mélangées aux plantes cultivées. Dans la mise au point d'un système de vision, il faut sélectionner les attributs les plus pertinents pour réaliser la discrimination. La réflectance et les paramètres de forme doivent être analysés au cas par cas, en fonction des variétés d'adventices susceptibles d'être présentes dans une culture donnée. La mesure de la hauteur des plantes est une méthode efficiente, puisqu'à faible échelle spatiale, la vitesse de croissance des plantes cultivées est plus uniforme que celle d'adventices appartenant à des espèces différentes. Cette vitesse de croissance est fonction de la hauteur et d'un temps caractéristique (par exemple, le nombre de jours après semis). La mise en œuvre de cette méthode peut être basée sur l'utilisation d'une méthode de stéréoscopie active combinée à la détermination précise du microrelief du sol.

Abstract

Machine vision is a method for the future to automatically recognize weeds from plants. Weeds compete with crop plants for sunlight, moisture and nutrients and can have a detrimental impact on crop yields and quality if uncontrolled. They are destroyed by chemical, non-chemical and integrated methods. To perform a site-specific weeds destruction, combination of these techniques with ground-based machine vision technology has high potential. Several methods exist to differentiate weeds from soil, between the rows. The more complicated problem is encountered when weeds are mixed to crops within the rows. Algorithms based on colorimetric or shape features are widely dependent on the variability of weeds and crops and are difficult to transpose from one situation to another. Measurement of plant height is a promising method, since at low spatial scale, the growing speed is more uniform for the plants than for the weeds. This growing speed is function of the height and of a characteristic time, such as the number of days after sowing. To implement this method, active stereoscopy combined to an accurate measurement of the soil microrelief is required.

1. Contexte général

1Les adventices sont des plantes indésirables présentes dans les champs cultivés. Ces « mauvaises herbes » sont considérées comme nuisibles parce qu'elles entrent en compétition avec les cultures pour la lumière, l'eau, les nutriments et l'espace. De ce fait, elles réduisent les rendements, peuvent rendre la récolte difficile et risquent d'affecter la qualité des produits. Même à faible densité, les adventices peuvent être nuisibles, en produisant des semences qui seront à l'origine d'infestations ultérieures. On cherche donc à les détruire même si elles participent à la biodiversité.

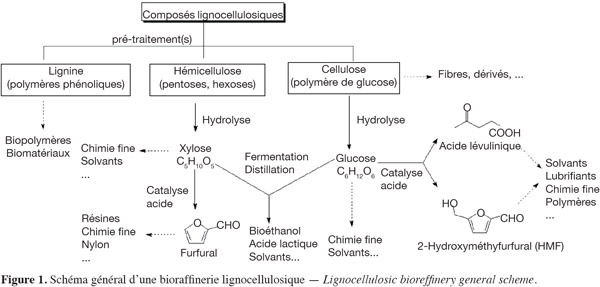

2Les techniques de désherbage peuvent être classées en méthodes chimiques, non chimiques et intégrées (Figure 1).

3Les méthodes chimiques, en recourant à l'utilisation d'herbicides, sont d'une utilisation aisée et possèdent une bonne efficacité (en général supérieure à 95 %). Cependant, l'emploi répété d'herbicides peut conduire à l'apparition de résistances et leur utilisation présente un cout élevé. Comme c'est le cas pour tous les pesticides, les herbicides présentent des risques pour l'environnement et l'utilisateur. À l'avenir, les applications d'herbicides devront vraisemblablement être davantage ciblées dans la mesure où les adventices font partie de l'écosystème et que leur destruction chimique peut avoir un impact sur le fonctionnement de celui-ci. Les récentes directives européennes règlementent d'ailleurs de manière de plus en plus stricte l'emploi des pesticides. À titre d'exemple, citons la Directive 2009/128/CE du 21 octobre 2009 qui instaure un cadre d'action communautaire pour parvenir à une utilisation des pesticides compatible avec le développement durable.

4Les méthodes intégrées recouvrent différents concepts. Selon la définition de l'OILP/SROP de 2004 (Boller et al., 2004), « la production intégrée est un système de production qui produit des aliments de haute qualité et d'autres matières premières en mobilisant les ressources et les mécanismes de régulation naturels pour remplacer les intrants polluants et sécuriser une agriculture durable ». Dans sa forme la plus simple, le contrôle intégré des adventices consiste à utiliser de manière combinée ou séquentielle plusieurs méthodes, qu'elles soient chimiques, non chimiques, physiques ou biologiques, pour lutter contre une ou plusieurs espèces d'adventices. Selon Bertrand et al. (2008), les principales tendances de la production intégrée consistent à raisonner davantage les successions culturales dans les systèmes à base de cultures annuelles, à modifier les calendriers culturaux en association avec le raisonnement de l'ensemble date de semis/densité de semis/choix de variété, à adapter des techniques de simplification de travail du sol (les résultats de ces dernières méthodes sont cependant très variables). Ces mêmes auteurs estiment que le contrôle intégré des adventices est amorcé mais encore imparfait. Pour progresser dans cette voie, il serait nécessaire de mieux connaitre les effets des pratiques agricoles, en interaction avec les variables caractéristiques de la flore (démographie, évolution génétique).

5Les techniques de désherbage non chimiques peuvent être différenciées selon qu'elles impliquent ou non une pénétration d'outils dans le sol. Les outils de désherbage mécanique qui pénètrent dans le sol, tels que sarcleuses, herses étrilles, houes rotatives, etc. ont une bonne efficacité sur des plantules jeunes tant que le sol reste sec pendant et après l'intervention (Kurstjens et al., 2001). Les destructions thermique ou électrique sont réalisées sans pénétration dans le sol et présentent de nombreuses variantes (http://www.organicweeds.org.uk).

6Quelle que soit la méthode utilisée (chimique, non chimique ou intégrée), la distribution spatiale non uniforme des populations d'adventices incite de plus en plus à réaliser des interventions modulées (en anglais, « site-specific ») pour réduire les couts financiers, les impacts environnementaux et le nombre de passages dans les parcelles.

7À cette fin, les techniques basées sur la télédétection multispectrale permettent de distinguer des zones dans lesquelles la densité d'adventices est élevée, uniforme et possède des caractéristiques spectrales bien définies mais ne sont pas efficientes lorsqu'elles sont disséminées au sein des cultures (Hatfield et al., 1993 ; Lamb et al., 2001). L'utilisation de capteurs localisés sur des machines à proximité du sol est plus prometteuse dans la mesure où ils permettent d'identifier, outre la réflectance, des attributs tels que la forme du feuillage, la texture, l'organisation des plantes, etc. (Brown et al., 2005).

8La mise en œuvre de ces capteurs se fera vraisemblablement à l'avenir en recourant à des robots (Blackmore et al., 2005). Outre la source d'énergie, un robot destiné à éliminer les adventices devrait comporter trois composants de base :

9– des capteurs pour détecter les adventices et assurer le guidage ;

10– un système d'aide à la décision pour traiter l'information issue des capteurs et définir les actions à exercer ;

11– des actionneurs pour éliminer les adventices de manière chimique, mécanique, électrique, thermique, etc. et assurer la progression de la machine.

12Le guidage d'un robot réalisé soit de manière locale par rapport aux rangs, soit de manière locale avec un système de positionnement de type RTKS, ne constitue plus un problème aujourd'hui. Des robots existent déjà pour détruire les adventices, soit sous forme de prototype (Lee et al., 1999 ; Astrand et al., 2002 ; Van Evert et al., 2006), soit sous forme commerciale. Par exemple, le robot Robotcrop InRow (http://www.garford.com) détruit les adventices situées entre des plantes maraichères dont l'espacement entre les lignes et dans la ligne est connu (persil, céleri, etc.) (Figure 2). Selon Slaughter et al. (2008), le problème majeur dans le développement de robots destructeurs d'adventices reste le manque de techniques robustes assurant la reconnaissance d'adventices.

13L'objectif de l'article est donc de faire le point sur les potentialités de la vision artificielle en tant qu'outil de différenciation des adventices par rapport aux plantes cultivées. Les caractéristiques mesurées sont la réflectance des végétaux, la forme, la texture ou la hauteur, pris isolément ou en combinaison.

2. La vision artificielle et la reconnaissance des adventices

14Le problème est compliqué du fait que l'on est amené à différencier des objets naturels à haute variabilité, par rapport à un arrière-plan qui possède lui-même des caractéristiques hautement aléatoires. Les nombreuses études consacrées à la reconnaissance des adventices varient en fonction de la complexité de la scène examinée : la différenciation de plantes individuelles peut s'effectuer par rapport à un arrière-plan fortement contrasté en laboratoire, elle peut concerner la reconnaissance d'adventices à partir d'images synthétiques (Vioix et al., 2002 ; Jones et al., 2009) ou bien la reconnaissance d'adventices en plein champ. La complexité est également liée au nombre de plantes étudiées (reconnaissance d'une ou de plusieurs espèces d'adventices), au nombre de variables non contrôlées (sol de texture uniforme ou sols de différentes textures), aux conditions d'acquisition d'images (statiques ou en mouvement), aux potentialités d'utilisation en temps réel, etc.

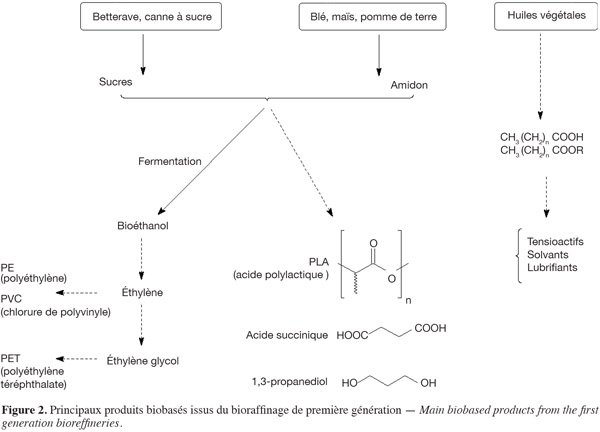

15Si on souhaite reconnaitre des adventices situés entre les rangs de plantes cultivées, la première étape consiste à identifier les lignes. La transformée de Hough est une méthode robuste pour ce faire (Astrand et al., 2005), d'autant plus qu'il est possible de tenir compte de l'existence d'un point de convergence des lignes perçues par la caméra (Leemans et al., 2006). Il reste alors à différencier les adventices par rapport au sol. Par contre, si les adventices sont situées dans les lignes et mélangées aux plantes cultivées, le problème est nettement plus complexe (Figure 3). Les méthodes utilisées se basent sur la mesure d'attributs tels que la réflectance, la morphologie, la texture, la hauteur, pris isolément ou en combinaison. Une fois mesurés, ces attributs sont introduits dans un classifieur de type analyse discriminante, maximum de vraisemblance, réseau de neurones, SVM (Support Vector Machine), logique floue, etc. (Marchant et al., 2003).

3. La réflectance

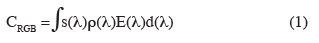

16Lorsqu'un être humain différencie des plantes cultivées d'adventices, la différence de couleur est un élément déterminant. Or, la couleur CRGB perçue par un système optique, comme une caméra RGB, est le résultat de l'intégration du produit du spectre de l'illuminant E(λ) par la réflectance des objets dans la scène () et par les caractéristiques spectrales du système optique s(λ), étant la longueur d'onde (Onyango et al., 2001) :

17Pour un système optique donné et un objet de réflectance déterminée, une modification du contenu spectral de l'illumination change donc la couleur de la scène.

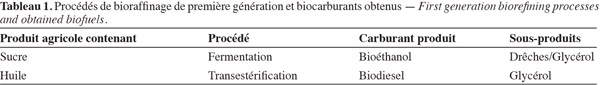

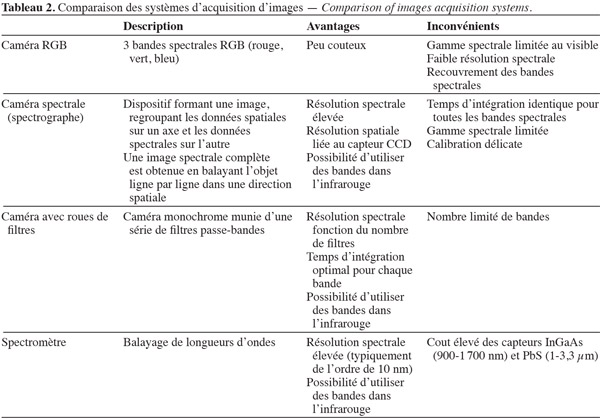

18La réflectance du feuillage a été étudiée par de nombreux auteurs (Parish, 1990 ; Thill et al., 1991 ; Thompson et al., 1991 ; Hatfield et al., 1993). La réflectance étant directement liée à l'absorption spectrale, il faut rappeler que les végétaux contiennent des pigments dont les bandes d'absorption sont bien définies (Tableau 1), les plus connus étant les chlorophylles contenues dans les chloroplastes. Seule une partie de l'énergie absorbée par les chlorophylles est utilisée pour la photosynthèse, le reste est restitué au milieu sous forme de fluorescence, à des longueurs d'onde plus élevées que celle de la lumière absorbée. Dans la zone du proche infrarouge (NIR), les végétaux présentent une réflectance importante, fortement influencée par l'organisation cellulaire. En effet, quand la radiation NIR pénètre les cellules du mésophylle, de multiples réflections et réfractions se produisent entre les cellules hydratées et les poches d'air qui les séparent et peu d'énergie est absorbée par la plante sous forme de NIR. Au-delà de 1 300 nm, la réflectance est fortement dépendante de la teneur en eau de la plante. Un feuillage convenablement hydraté présente des pics de réflectance dans la zone de 1 300 à 2 500 nm. Ces pics n'apparaissent pas si le feuillage est déshydraté (Thorp et al., 2004). Du fait de l'ensemble de ces éléments, la réflectance subit des variations temporelles en cours de saison culturale, dues aux modifications de taille des cellules, de composition chimique, de teneur en eau et d'une manière plus générale, en raison de la présence de facteurs de stress (Zwiggelaar, 1998).

19Même si la réflectance d'une feuille en est l'élément déterminant, l'énergie réfléchie par la canopée est fonction de plusieurs variables : le LAI (indice foliaire), la réflectance du sol (qui varie en fonction de la teneur en eau, de la présence de matière organique, etc.), l'angle des feuilles, etc. La réflectance est aussi influencée par la teneur en azote et l'état sanitaire de la canopée. Dans les études mesurant les différences de réflectance qui existent entre les adventices et les plantes cultivées, l'acquisition d'images est réalisée avec des caméras conventionnelles RGB, des dispositifs multispectraux ou hyperspectraux. Parmi ces derniers, on trouve des spectrographes ou caméras spectrales et des spectromètres. Les avantages et inconvénients des différentes techniques sont résumés dans le tableau 2.

20Par ailleurs, plusieurs auteurs font état de la difficulté de reconnaitre des végétaux dans un environnement extérieur (Tian et al., 1993 ; Steward et al., 1999). L'illumination directe provoque d'importantes différences d'intensités dans les images, selon que l'on est en présence d'ombres ou de réflexions spéculaires dues à des feuillages brillants. Par ailleurs, l'illumination extérieure est non uniforme, en intensité et en contenu spectral. Il semble possible d'obtenir de meilleurs résultats en milieu extérieur, en contrôlant l'illumination, en recourant à un algorithme de segmentation adaptative (Tian et al., 1998) ou bien encore en utilisant deux caméras munies de filtres, l'un correspondant à une zone d'absorption de la lumière, l'autre à une zone de réflexion importante (NIR) et en soustrayant les deux images (Gerhards et al., 2003 ; Astrand et al., 2005). Slaughter et al. (2008) font remarquer que cette dernière méthode est peu efficace dans des régions d'Europe du Sud ou la Califormie, dans lesquelles le rapport entre l'illumination diffuse et l'illumination globale (illumination directe + diffuse) est faible, alors qu'il est élevé en Europe du Nord. Pour pouvoir faire abstraction des variations de l'illumination, un éclairage contrôlé est utilisé sur différents prototypes (Lee et al., 1999 ; Hemming et al., 2001 ; Piron et al., 2008a).

3.1. Acquisition d'images par caméras

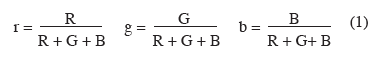

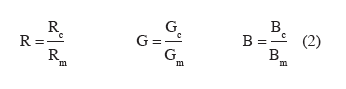

21Plusieurs auteurs utilisent des caméras RGB pour différencier les végétaux du sol. Trois catégories de méthodes sont utilisées. Les premières consistent à synthétiser l'information contenue dans les images en calculant des indices de chromaticité et en définissant un seuil séparant les végétaux du sol. Woebbecke et al. (1995) utilisent les indices de chromaticité définis de la manière suivante :

22Dans cette expression, R, G et B sont les variables rouge, verte et bleue mesurées par la caméra et normalisées comme suit :

23Rc, Gc, Bc sont respectivement les valeurs moyennes des réflectances dans les canaux rouge, vert et bleu et Rm, Gm, Bm sont respectivement les valeurs maximales correspondantes. Puisque r+g+b = 1, seuls deux indices de chromaticité sont indépendants. Les auteurs montrent que la meilleure séparation est obtenue en utilisant l'indice ExG (Excessive Green) qui est une combinaison linéaire de r, g et b :

24Cet indice se révèle inefficace pour différencier les monocotylées des dicotylées mais est souvent utilisé pour différencier la végétation du sol (Sogaard, 2005 ; Nieuwenhuizen et al., 2007 ; Burgos-Artizzu et al., 2010). D'autres indices sont proposés avec le même objectif :

25– l'indice ExR (Excess Red Index) (Meyer et al., 1998) :

26– l'indice de chromaticité vert (Astrand et al., 2002) :

27Ce dernier indice est utilisé pour reconnaitre les adventices situées dans l'inter-rang de betteraves (Astrand et al., 2002). Le système d'identification des adventices est monté sur un robot, conjointement à un système de vision noir et blanc qui assure le guidage de la machine via une transformée de Hough. Sur base d'essais réalisés en serre, la précision de la classification atteint 91 %.

28Les méthodes de la deuxième catégorie sont des méthodes de segmentation dynamique, comme la méthode d'Otsu (Shrestha et al., 2004) ou une méthode hybride combinant l'algorithme « mean shift » proposé par Comaniciu et al. (2002) et une analyse discriminante linéaire (Zheng et al., 2010).

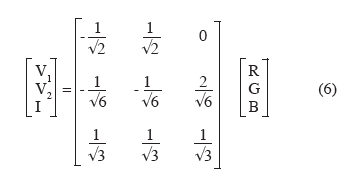

29Dans la troisième catégorie, on trouve des méthodes qui consistent à opérer des transformations de l'espace couleur. La transformation utilisée par Stewart et al. (1999) et Vioix et al. (2002) :

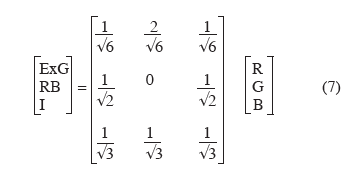

30a pour but de séparer l'information intensité de l'information couleur. Il s'agit d'une rotation du repère RGB de telle sorte que l'axe I coïncide avec l'axe des intensités et que V1 et V2 définissent un plan perpendiculaire à I et parallèle au triangle des couleurs. La transformation proposée par Nieuwenhuizen et al. (2007) poursuit les mêmes objectifs :

31RB est la différence R-B. Cette transformation est utilisée pour reconnaitre des pommes de terre volontaires dans un champ de betteraves sucrières. En fonction du type de champ, des conditions d'ensoleillement, du stade des végétaux, le taux de reconnaissance correct varie de 49 à 97 %.

3.2. Acquisition d'images par dispositif hyperspectral

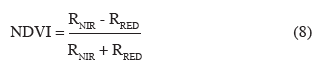

32Considérant qu'une caméra RGB fournit une information spatiale détaillée mais comporte seulement trois bandes (rouge, vert, bleu) de faible résolution spectrale, plusieurs auteurs utilisent un dispositif hyperspectral ou multispectral. Pour différencier des betteraves (Beta vulgaris L.) de plantes adventices, telles que Poa annua L., Plantago lanceolata L., Stellaria media L., Chenopodium album L., Feyaerts et al. (2001) conçoivent un spectrographe (aussi appelé caméra spectrale) qui décompose la lumière reçue en ses composantes spectrales et les projette sur la matrice de capteurs d'une caméra monochrome. L'un des axes se comporte comme un axe spatial, tandis que le deuxième axe est un axe spectral possédant une résolution de 35 nm dans une gamme de 435 à 1 000 nm. Le proche infrarouge étant accessible, la végétation est d'abord segmentée par rapport à l'arrière-plan en utilisant l'indice NDVI :

33Ensuite, différents classifieurs sont testés, les meilleurs résultats étant obtenus avec un MLNLM (multi-layer neural network with non linear mapping). En utilisant les longueurs d'onde de 441, 446, 459, 883, 924 et 988 nm, un taux de classification correct allant jusqu'à 83 % est obtenu.

34Le même principe est mis en œuvre par Vrindts et al. (2002) qui utilisent un dispositif hyperspectral commercial fonctionnant dans une gamme de 480 à 820 nm. Avec ce dispositif, les auteurs arrivent à classer correctement 93 % des spectres avec neuf bandes spectrales en betteraves et 91 % avec 8 bandes en maïs. Ces résultats favorables ne sont toutefois obtenus que lorsque les conditions d'illumination extérieures restent inchangées.

35Okamoto et al. (2007) utilisent un dispositif hyperspectral dans la bande de 400 à 1 000 nm, avec une résolution de 10 nm. Les images acquises sur deux sites, en conditions ensoleillées et nuageuses, ont pour objectif de séparer des betteraves de quatre espèces d'adventices : Fallopia convolvulus L., Equisetum arvense L., Setaria viridis L., Stellaria media. Pour réduire les effets dus aux fluctuations spectrales de l'illuminant, les données sont normalisées (l'intensité minimum est ramenée à 0, tandis que l'intensité moyenne est ramenée à 1). La séparation des pixels de végétaux (plantes cultivées et adventices) de ceux du sol est basée sur le calcul de la distance euclidienne. Dans une deuxième étape, les pixels des plantes sont séparés de ceux d'adventices en utilisant une transformation en ondelettes de type Daubechies avant de procéder à une analyse discriminante linéaire. Les taux de classification corrects sont compris entre 75 et 80 %.

36Slaughter et al. (2004) montrent l'intérêt de travailler dans des bandes du proche infrarouge, avec une haute résolution spectrale pour séparer des plantes dont les spectres sont très proches les uns des autres. Ils utilisent un spectromètre dont la gamme de longueurs d'ondes est comprise entre 400 et 2 500 nm pour différencier des feuilles de végétaux appartenant tous deux à la famille des Solanacées (des tomates, Lycopersicum esculentum L. et de la belladone, Atropa belladonna L.), matures et en bon état, prélevées sur les plantes. Les meilleurs résultats sont obtenus dans les bandes d'absorption situées entre 1 700 et 1 900 nm et 2 120 et 2 320 nm en utilisant un modèle discriminant multivarié. Malgré les bons résultats obtenus, la méthode semble difficilement transposable à l'étude de la végétation située en champ du fait que l'angle de mesure influence les résultats, que des longueurs d'onde émises sur le feuillage peuvent se situer dans des bandes concernées par la fluorescence, que le spectre peut varier du fait de la non-uniformité du feuillage, etc.

3.3. Acquisition d'images par dispositif multispectral

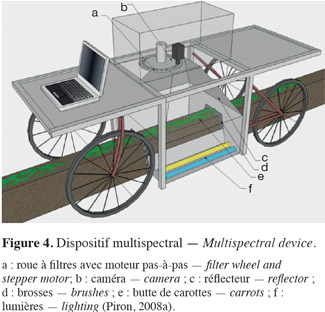

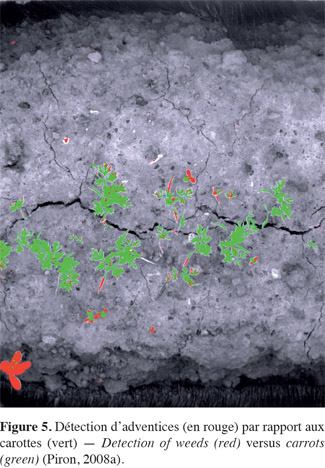

37Vioix et al. (2004) réalisent un dispositif multispectral comportant quatre filtres montés sur un carrousel devant l'objectif d'une caméra embarquée dans un avion dont l'altitude varie de 10 à 100 m. Les caractéristiques des filtres ne sont cependant pas spécifiées. Pour détecter des adventices (Sonchus asper L., Chenopodium L., Achenocloa, Cirsium Mill., Mercurialis perennis L., Brassica L. et Matricaria maritima L.) par rapport à des carottes (Daucus carota L.) en plein champ, Piron et al. (2008a) utilisent un dispositif fonctionnant en lumière contrôlée (Figure 4). Ce dispositif multispectral est constitué d'une caméra noir et blanc couplée à une roue commandée par un moteur pas-à-pas qui comporte 22 filtres. Leur longueur d'onde centrale est comprise entre 450 à 950 nm et la largeur de bande varie entre 40 et 100 nm. Les auteurs montrent que les longueurs d'ondes les plus appropriées à la reconnaissance des adventices dans les carottes sont de 450, 550 et 700 nm et qu'il est possible d'obtenir un taux de classification correct de 72 %. Les cotylédons sont systématiquement mal classés (Figure 5), ce qui confirme les résultats d'études antérieures montrant que les caractéristiques spectrales de ces derniers sont différentes de celles de la plante (Franz et al., 1991b ; Gee et al., 2004).

4. Morphologie des végétaux

38Les plantes cultivées se différencient des adventices par leur morphologie et les premières études utilisent des coefficients de forme tels que la circularité, l'élongation, l'excentricité, etc. (Lee et al., 1999). Cependant, ces méthodes se heurtent à deux difficultés majeures. Pour une même espèce, la variabilité du feuillage est telle que des techniques classiques d'ajustement de patrons (« pattern maching ») ne sont donc pas adaptées. Par ailleurs, vues à partir du capteur optique (caméra, dispositif multispectral ou hyperspectral), les feuilles sont souvent superposées ; il n'est donc pas possible de percevoir certaines d'entre elles dans leur entièreté (Franz et al., 1991a).

39Pour séparer des feuilles superposées, Lee et al. (2004) partent d'un algorithme de segmentation de type « watershed » qui considère une image en niveau de gris comme un relief topographique sur lequel on peut déterminer des lignes de partage des eaux. Constatant que cet algorithme conduit à une séparation excessive et donc une fragmentation trop élevée, ils lui apportent certaines modifications, essentiellement constituées d'opérations morphologiques.

40Sogaard (2005) constitue une base de données d'images bidimensionnelles de 19 espèces d'adventices existant au Danemark, obtenues en conditions d'illumination contrôlée. Les pixels des végétaux sont séparés de ceux du sol en utilisant l'indice ExG, puis transformés en niveaux de gris. Un algorithme basé sur les contours actifs est utilisé pour caractériser la forme moyenne des 19 catégories d'adventices. Il s'agit de définir un contour initial entourant la plante, puis de déplacer les points qui le constituent pour les rapprocher de zones de fort gradient en conservant certaines caractéristiques comme la courbure. À l'aide de cette technique, Sogaard arrive à modéliser la forme des feuilles et la structure de la plante entière jusqu'au stade 2 feuilles. La classification est basée sur l'importance des déplacements à appliquer pour obtenir un ajustement parfait. Les taux de reconnaissance corrects varient de 65 à 90 %.

5. Texture

41La texture, qui se réfère aux propriétés de surface des végétaux, est assez peu utilisée en tant que seul attribut pour différencier les adventices des plantes cultivées. Burks et al. (2000) utilisent des attributs de texture pour classer cinq espèces d'adventices produites en pots (Ipomoea hederaceae Jacq., Setaria faberi Herrm., Digitaria Sanguinalis L., Abutilon theophrasti Medik., Chenopodium album L.). Les images acquises dans l'espace RGB sont transformées dans l'espace couleur HSI et les matrices de co-occurrence, qui analysent la fréquence avec laquelle se répète l'intensité d'un attribut colorimétrique, sont calculées. Elles permettent de générer 33 attributs de texture pour chaque image. Les potentialités de trois classifieurs basés sur différents types de réseaux de neurones sont analysées sur base de la précision de la classification, du nombre d'éléments nécessaires pour l'apprentissage et du temps de calcul (Burks et al., 2005). Il apparait qu'une procédure de type « stepwise » permettant de réduire la quantité de données à introduire dans le réseau de neurones est un élément favorable pour éliminer les données redondantes et réduire le temps de calcul.

6. Hauteur

42Pour mesurer la hauteur, la méthode la plus connue est la stéréoscopie passive qui consiste à observer la scène à partir d'au moins deux points de vue et à trouver des correspondances entre les différentes images pour établir les coordonnées des pixels par triangulation. C'est ainsi que Nielsen et al. (2004) cherchent à détecter des adventices par rapport à des plants de tomates en analysant des images stéréoscopiques acquises dans une serre équipée de pare-soleil, à l'aide d'une caméra trinoculaire. La distinction entre plantes et adventices est basée sur trois méthodes différentes :

43– mesure de la distance entre la caméra et les pixels de plantes : cette technique nécessite de connaitre la distance entre la caméra et le sol pour définir une valeur seuil au-delà de laquelle les pixels appartiennent aux plantes cultivées ou aux adventices ;

44– analyse de groupes de pixels séparés sur base d'un histogramme : avec cette méthode, beaucoup d'objets sont fusionnés. Par exemple, des branches de plants de tomates proches du sol ne sont pas segmentés comme appartenant à la plante ;

45– analyse de ces groupes à l'aide d'un algorithme de type « watershed » : il existe des incertitudes au niveau des pixels se trouvant à la frontière plantes/adventices.

46Les auteurs reconnaissent que les algorithmes de classification sont perfectibles et que la prise en compte des irrégularités du sol pourrait améliorer la classification.

47Quand la scène ne contient pas d'éléments particuliers pour établir une correspondance, comme c'est généralement le cas dans les scènes naturelles, la stéréoscopie active basée sur l'utilisation d'une lumière structurée est plus appropriée.

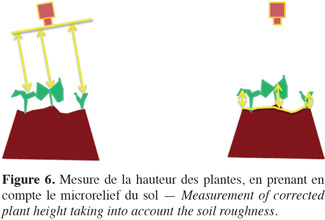

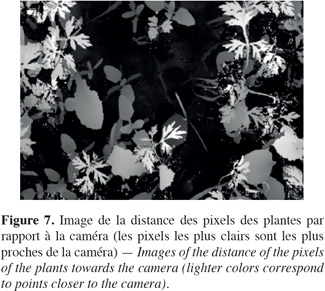

48Pour mesurer la hauteur des pixels, Piron et al. (2011) utilisent une méthode de stéréoscopie active, qui repose sur le principe suivant : un projecteur vidéo projette sur la scène à analyser une série de franges lumineuses noires et blanches codées. La scène perçue via le code lumineux par une caméra laisse alors apparaitre des distorsions de ligne qui contiennent l'information de relief. Les codes projetés ont deux caractéristiques : ils sont aléatoires et très faiblement corrélés entre eux. Du fait de la grande plage dynamique et de la non-uniformité de réflectance de la scène, l'acquisition d'une image se fait en fusionnant des images intermédiaires d'expositions multiples. Autrement dit, chaque image est formée de plusieurs images intermédiaires prises avec des temps d'exposition différents, afin que tous les points de la scène soient correctement exposés. Le principe de décodage repose sur la corrélation entre les signaux émis et les signaux reçus. Cette méthode permet d'obtenir la distance entre les pixels des végétaux et la caméra avec une grande précision. Sur le terrain, le problème est cependant rendu plus compliqué par le fait que le micro-relief sous la végétation est inégal, ce qui implique de corriger les distances caméra-objet en modélisant le relief du sol (Figure 6). Une « reconstitution » du sol sous les plantes est réalisée par interpolation polynomiale à partir des pixels de sol visibles sur les images, ce qui permet d'obtenir de façon très précise la « hauteur corrigée », c'est-à-dire la distance des pixels des végétaux par rapport à la caméra (Figure 7) (Piron et al., 2008b). La différenciation plantes – adventices est alors basée sur le fait qu'à faible échelle spatiale, on peut considérer que la vitesse de croissance de plantes cultivées est plus uniforme que celle d'adventices représentés par des espèces différentes. Cette vitesse de croissance est fonction de la hauteur et d'un temps caractéristique (par exemple, le nombre de jours après semis). Cette méthode permet d'obtenir une précision de classification de 83 %.

7. Combinaison de plusieurs attributs

49Hemming et al. (2001) cherchent à reconnaitre des adventices par rapport à des plantes maraichères (carottes et choux) en plein champ, avec un dispositif travaillant en lumière contrôlée. Trois attributs colorimétriques (les variables HSI, à savoir la teinte, l'intensité et la saturation) et huit attributs morphologiques (aire, aire/périmètre, longueur/largeur, circularité, convexité, etc.) sont extraits des images. Les plus pertinents d'entre eux sont introduits dans un algorithme de logique floue. En fonction du stade de croissance, la précision de la classification varie de 51 à 95 %.

50Onyango et al. (2003) développent un algorithme de segmentation basé sur la couleur (valeurs R, G, B conventionnelles) et la connaissance a priori de l'espacement entre plantes (choux-fleurs) grâce à une filtration morphologique et un ajustement de droites permettant de déterminer le centre des plantes. La distribution de probabilité des pixels de plantes est modélisée autour de ceux-ci par une distribution de Gauss à deux dimensions. La précision de la classification varie entre 82 et 96 %.

51Van Evert et al. (2006) montent deux webcams sur un petit robot de faible cout, en vue d'étudier la possibilité de détecter la présence de pommes de terre volontaires dans un champ de maïs. À l'aide de la première caméra, les rangs de maïs sont modélisés par une transformée de Hough. À partir de la deuxième, les adventices sont détectées sur base d'une combinaison d'attributs de taille, forme et couleur. Le taux de reconnaissance correct des adventices varie de 90 à 98 %.

52Gebhardt et al. (2007) cherchent à détecter Rumex obtusifolius, Taraxacum officinale F.H.Wigg. et Plantago major L. dans des gazons sur la base d'attributs de couleur (intensité, valeurs R et G), forme (aire, périmètre, excentricité, circularité) et texture (moyenne des gradients) introduits dans un classifieur de type maximum de vraisemblance. Les attributs de forme apparaissent moins pertinents que les attributs de couleur et de texture, dans la mesure où le recouvrement des adventices est important par rapport au gazon, à tous les stades de croissance. Les taux de classification corrects de Rumex obtusifolius L. sont élevés (95 %) mais varient en fonction du stade phénologique de la végétation.

53Combinant la hauteur des pixels et la réflectance pour différencier des plants de carottes de Sonchus asper L., Chenopodium, Achenocloa, Cirsium, M. perennis, Brassica et Matricaria maritima, Piron et al. (2009) observent que le second attribut n'améliore que très peu la précision de la classification. Ceci est dû au fait que les deux variables, hauteur et réflectance, sont étroitement corrélées entre elles.

8. Systèmes d'aide à la décision

54La qualité des algorithmes de reconnaissances des adventices influence fortement la précision de la pulvérisation : un algorithme générant des incertitudes au niveau des pixels à la frontière plantes/adventices pourra être utilisé avec une large zone de sécurité pour protéger les plantes cultivées, pour autant que l'on accepte l'existence d'adventices résiduelles ; un algorithme de type « watershed » qui fragmente exagérément les objets risque de conduire à une pulvérisation excessive ; etc.

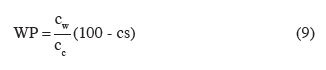

55Au-delà de la mise au point des algorithmes, il reste à déterminer le seuil d'infestation au-delà duquel il convient d'intervenir. Selon Burgos-Artizzu et al. (2010), un indice tel que le « Weed Pressure » (WP) pourrait servir de base pour définir la dose d'herbicide à appliquer :

56avec cw : pourcentage de couverture par les adventices ; cc : pourcentage de couverture par les plantes cultivées ; cs : pourcentage de sol.

57Si le sol a été au préalable éliminé des images, le critère retenu est un seuil dépassant une certaine proportion de surface adventices/plantes. Le seuil est de 10 % chez Nielsen et al. (2004), qui cherchent à éliminer les adventices de tomates, et de 20 % chez Berge et al. (2008) qui travaillent sur le blé.

58Considérant que la segmentation d'adventices par rapport aux plantes cultivées dépend de nombreux éléments, comme l'illumination, le type de végétaux en présence, leur stade de croissance, etc., la décision de traiter est basée sur le calcul de la probabilité a posteriori établie à partir du théorème de Bayes (Tellaeche et al., 2007), par SVM (Support Vector Machine) (Tellaeche et al., 2010) ou à l'aide d'un algorithme génétique (Burgos-Artizzu et al., 2010).

9. Conclusion

59Dans la mise au point d'un système localisé de destruction des adventices, il y a lieu de distinguer trois cas. Dans le premier cas, les adventices sont situées dans l'interligne. Il est possible de les différencier facilement du sol, notamment en utilisant un indice de chromaticité. Dans le deuxième cas, les adventices sont situées dans la ligne cultivée mais les plantes (le plus souvent des plantes maraichères) y sont régulièrement espacées : on possède donc une connaissance a priori de l'espacement des cultures dans la ligne qu'il est possible d'exploiter pour détecter les adventices. Des réalisations commerciales mettant en œuvre ce principe existent déjà. Dans le troisième cas, les adventices sont situées dans une ligne de plantes cultivées possédant une haute densité. Dans cette situation, on constate que les caractéristiques spectrales n'apportent pas de solution robuste pour reconnaitre différents types de végétaux.

60Dans les meilleurs des cas, il est possible de différencier des cultures données par rapport à certaines catégories d'adventices en utilisant des longueurs d'onde particulières, mais aucune solution générique ne peut être dégagée. Utiliser des bandes spectrales sans recouvrement et à haute résolution et travailler dans la zone d'absorption de la lumière par le feuillage (proche infrarouge) sont des éléments favorables.

61Les plantes cultivées se différencient des adventices par leur morphologie. Cependant, vues à partir du capteur optique, les feuilles sont souvent superposées ; il n'est donc pas possible de percevoir certaines d'entre elles dans leur entièreté et les algorithmes de reconnaissance de forme sont souvent peu efficaces.

62À faible échelle spatiale, on peut considérer que la vitesse de croissance des plantes cultivées est plus uniforme que celle des adventices représentées par des espèces différentes. La mesure précise de la hauteur des végétaux, couplée à un temps caractéristique (par exemple, le nombre de jours après semis), permet de différencier les pixels des plantes cultivées de ceux des adventices. La combinaison d'attributs, tels que réflectance et hauteur, ne permet pas d'améliorer la précision de la classification, dans la mesure où ces attributs sont corrélés entre eux. La solution consistant à mesurer avec précision la hauteur des adventices par rapport à celle des plantes cultivées est donc une solution d'avenir, pour autant que la mesure de hauteur prenne en compte les irrégularités du microrelief du sol. Cette méthode devrait être implémentée sur un prototype pour être évaluée dans des conditions expérimentales variées.

63Remerciements

64Cette étude a été réalisée dans le cadre du projet RECADVEN, financé par la DGO6.

Bibliographie

Astrand B. & Baerveldt A.-J., 2002. An agricultural mobile robot with vision-based perception for mechanical weed control. Auton. Robots, 13, 21-35.

Astrand B. & Baerveldt A.-J., 2005. A vision based row-following system for agricultural field machinery. Mechatronics, 15, 251-269.

Berge T., Aastveit A. & Fykse H., 2008. Evaluation of an algorithm for automatic detection of boad-leaved weeds in spring cereals. Precis. Agric., 9, 391-405.

Bertrand M. & Doré T., 2008. Comment intégrer la maîtrise de la flore adventice dans le cadre général d'un système de production intégrée ? Innovations Agron., 3, 1-13.

Blackmore S., Stout B., Wang M. & Runov B., 2005. Robotic agriculture – the future of agricultural mechanization? In: Proceedings of the 5th European Conference on Precision Agriculture, 9-12/06/2005, Uppsala, Sweden, 621-628.

Boller E.F. et al., 2004. Integrated production: principles and technical guidelines. IOPC wprs Bull., 27(2).

Brown R.B. & Noble S.D., 2005. Site-specific weed management: sensing requirements. What do we need to see? Weed Sci., 53(2), 252-258.

Burgos-Artizzu X., Ribeiro A., Tellaeche A. & Pajares G., 2010. Analysis of natural images processing for the extraction of agricultural elements. Image Vision Comput., 28, 138-149.

Burks T.F., Shearer S.A. & Payne F.A., 2000. Classification of weed species using color texture features and discriminant analysis. Trans. ASAE, 43(2), 441-448.

Burks T.F., Shearer S.A., Heath J.R. & Donohue K.D., 2005. Evaluation of neural-networks classifiers for weed species discrimination. Biosystems Eng., 91(3), 293-304.

Comaniciu D. & Meer P., 2002. Mean shift: a robust approach toward feature space analysis. IEEE Trans. Pattern Anal. Mach. Intell., 24(5), 603-619.

Commission européenne, 2009. Directive 2009/128/CE du Parlement européen et du Conseil du 21 octobre 2009 instaurant un cadre d'activité communautaire pour parvenir à une utilisation des pesticides compatible avec le développement durable. J. Off. Union Eur., 24.11.2009, L309, 71-85.

Feyaerts F. & Van Gool L., 2001. Multi-spectral vision system for weed detection. Pattern Recognit. Lett., 22, 667-674.

Franz E., Gebhardt M.R. & Unklesbay K.B., 1991a. Shape description of completely visible and partially occluded leaves for identifying plants in digital images. Trans. ASAE, 34(2), 673-681.

Franz E., Gebhardt M.R. & Unklesbay K.B.,1991b. The use of local spectral properties of leaves as an aid for identifying weed seedlings in digital images. Trans. ASAE, 34(2), 682-687.

Gebhardt S. & Kühbauch W., 2007. A new algorithm for automatic Rumex obtusifolius detection in digital images using colour and texture features and the influence of image resolution. Precis. Agric., 8(1), 1-13.

Gee C., Bonvarlet L., Magnin-Robert J.B. & Guillemin J.P., 2004. Weed discrimination by reflectance measurements using neural networks. In: 12e Colloque international sur la biologie des mauvaises herbes, 31.08-02.09, Dijon, France. Paris: Association Française de Protection des Plantes (AFPP), 487-494.

Gerhards R. & Christensen S., 2003. Real-time weed detection, decision making and patch spraying in maize, sugarbeet, winter wheat and winter barley. Weed Res., 43, 385-392.

Hatfield J.L. & Pinter P.J., 1993. Remote sensing for crop protection. Crop Prot., 12(6), 403-413.

Hemming J. & Rath T., 2001. Computer-vision-based weed identification under field conditions using controlled lighting. J. Agric. Eng. Res., 78(3), 233-243.

Jones G., Gee C. & Truchetet F., 2009. Assessment of an inter-row weed infestation rate on simulated agronomic images. Comput. Electron. Agric., 67(1-2), 43-50.

Kurstjens D.A.G. & Kropff M.J., 2001. The impact of uprooting and soil-covering on the effectiveness of weed harrowing. Weed Res., 41, 211-228.

Lamb D.W. & Brown R.B., 2001. Remote-sensing and mapping of weeds in crops. J. Agric. Eng. Res., 78, 117-125.

Lee W.S., Slaughter D.C. & Giles D.K., 1999. Robotic weed control system for tomatoes. Precis. Agric., 1, 95-113.

Lee W.S. & Slaughter D.C., 2004. Recognition of partially occluded plant leaves using a modified watershed algorithm. Trans. ASAE, 47(4), 1269-1280.

Leemans V. & Destain M.-F., 2006. Line cluster detection using a variant of the Hough transform for culture row localisation. Image Vision Comput., 24, 541-550.

Marchant J.A. & Onyango C.M., 2003. Comparison of a Bayesian classifier with a multilayer feed-forward neural network using the example of plant/weed/soil discrimination. Comput. Electron. Agric., 39, 3-22.

Meyer G.E., Hindman T.W. & Lakshmi K., 1998. Machine vision detection parameters for plant species identification. Bellingham, WA, USA: SPIE.

Nielsen M., Andersen H., Slaughter D. & Giles D., 2004. Detecting leaf features for automatic weed control using trinocular stereo vision. In: International Conference on Precision Agriculture 2004, Minneapolis, MN, USA.

Nieuwenhuizen A.T. et al., 2007. Colour based detection of volunteer potatoes as weeds in sugar beet fields using machine vision. Precis. Agric., 8, 267-278.

Okamoto H., Murata T., Kataoka T. & Hata S., 2007. Plant classification for weeds detection using hyperspectral imaging with wavelet analysis. Weed Biol. Manage., 7(1), 31-37.

Onyango C.M. & Marchant J.A., 2001. Physics-based colour image segmentation for scenes containing vegetation and soil. Image Vision Comput., 19, 523-538.

Onyango C.M. & Marchant J.A., 2003. Segmentation of row crop plants from weeds using colour and morphology. Comput. Electron. Agric., 39(3), 141-155.

Parish S., 1990. A review of non-chemical weed control techniques. Biol. Agric. Hortic., 7, 117-137.

Piron A. et al., 2008a. Selection of the most efficient wavelength bands for discriminating weeds from crop. Comput. Electron. Agric., 62, 141-148.

Piron A., Leemans V., Kleynen O. & Destain M.-F., 2008b. Determination of plant height for weed detection in stereoscopic images. In: Agricultural Engineering Conference 2008, Hersonissos, Greece.

Piron A., Leemans V., Lebeau F. & Destain M.-F., 2009. Improving in-row weed detection in multispectral stereoscopic images. Comput. Electron. Agric., 69, 73-79.

Piron A., van der Heijden F. & Destain M.-F., 2011. Weed detection in 3D images. Precis. Agric., 12(5), 607-622.

Shrestha D.S., Stewart B.L. & Birrell S.J., 2004. Video processing for early stage maize plant detection. Biosyst. Eng., 89(2), 119-129.

Slaughter D.C., Lanini W.T. & Giles D.K., 2004. Discriminating weeds from processing tomato plants using visible and near-infrared spectroscopy. Trans. ASAE, 47(6), 1907-1911.

Slaughter D.C., Giles D.K. & Downey D., 2008. Autonomous robotic weed control systems: a review. Comput. Electron. Agric., 61, 63-78.

Sogaard H.T., 2005. Weed classification by active shape models. Biosyst. Eng., 91(3), 271-281.

Steward B. & Tian L., 1999. Machine-vision weed density estimation for real-time, outdoor lighting conditions. Trans. ASAE, 42(6), 1897-1909.

Tellaeche A., Burgos-Artizzu X.P., Pajares G. & Ribeiro A., 2007. A vision-based method for weeds identification through the Bayesian decision theory. Pattern Recognit., 41(2), 521-530.

Tellaeche A., Pajares G., Burgos-Artizzu X.P. & Ribeiro A., 2010. A computer vision approach for weeds identification through Support Vector Machines. Appl. Soft Comput., doi:10.1016/j.asoc.2010.01.011.

Thill D.C., Lish J.M., Callihan R.H. & Bechinski E.J., 1991. Integrated weed management – a component of integrated pest management: a critical review. Weed Technol., 5, 648-656.

Thompson J.F., Stafford J.V. & Miller P.C.H., 1991. Potential for automatic weed detection and selective herbicide application. Crop Prot., 10, 254-259.

Thorp K.R. & Tian L.F., 2004. A review of remote sensing of weeds in agriculture. Precis. Agric., 5, 477-508.

Tian L. & Slaughter D.C., 1993. Computer vision identification of tomato seedlings in natural outdoor scenes. ASAE Paper, N°93-3608.

Tian L. & Slaughter D.C., 1998. Environmentally adaptive segmentation algorithm for outdoor image segmentation. Comput. Electron. Agric., 21, 153-168.

Van Evert K.K. et al., 2006. A mobile field robot with vision-based detection of volounter potato plants in a corn crop. Weed Technol., 20(4), 853-861.

Vioix J.-B. et al., 2002. Spatial and spectral methods for weeds detection and localization. Eurasip J. Appl. Signal Process., 7, 679-685.

Vioix J.-B., Douzals J.-P. & Truchetet F., 2004. Development of a multispectral imagery device devoted to weed detection. J. Electron. Imaging, 13(3), 547-552.

Vrindts E., De Baerdemaeker J. & Ramon H., 2002. Weed detection using canopy reflection. Precis. Agric., 3(1), 63-80.

Woebbecke D.M., Meyer G.E., Von Bargen K. & Mortensen D.A., 1995. Color indices for weed identification under various soil, residue, and lighting conditions. Trans. ASAE, 38(1), 259-264.

Zheng L., Daming S. & Jingtao Z., 2010. Segmentation of green vegetation of crop canopy images on mean shift and Fisher linear discriminant. Pattern Recognit. Lett., 31(9), 920-925.

Zwiggelaar R., 1998. A review of spectral properties of plants and their potential use for crop/weed discrimination in row-crops. Crop Prot., 17(1), 189-206.